一道中学数学题,难倒几个AI大模型

0赞一道中学数学题,难倒几个AI大模型

-- 测试AI大语言模型ChatGPT、Gemini和MathGPT的数学解题能力

十年没有写博客了,竟发现我过去写的博客都还在,真该谢谢《电子技术应用》网站还保留着我的老博客。

大语言模型ChatGPT的出现,预示着一场新技术的爆发。时代迫使我这个退休快20年,已进入耄耋之年的老人从零开始了解AI技术,希望不要被时代抛得太远。

最近,在学习、探索过程中,做了一项测试,我把它记述如后。

不久前,我出了个“沙漠取宝”的题目给我的小孙子(美国小学五年级)做:

沙漠取宝

在离营地100公里的沙漠中有一个宝贝,中间无人烟,开汽车去取。汽车每公里要消耗1升的油,汽车最多可以装100升的油。怎样才能把宝贝取回来?

隐约记得六十多年前(那时我还是高中生),1962年的北京市中学生数学竞赛有过一道类似的题目,并要求给出最优解。根据一点印象,我把它改编成上面的“沙漠取宝”题目,放弃了最优解这一要求。

这是一个运筹学的题目,没有什么计算难度,从小学生到七、八十岁的老人,只要肯动脑思考,都可以筹划出一个办法把宝取回来。至于是否最优解,那是另外一码事。

突然想到,一些公开的AI大语言模型都有相当高的智能,是否可以用这个题目来试试他们的数学解题能力。因为我用的是美国手机号,无法注册国内的“文心一言”和“智谱清言”,所以只对OpenAI的ChatGPT和谷歌的Gemini(原Bard)作了测试。

对于AI大语言模型ChatGPT和Gemini的数学解题能力,我个人的初步判断:

1. ChatGPT有一定的数学功底,一开始就认准了题目的类型:“这个问题涉及一种经典的运输问题”。尽管也屡犯错误,例如几次让没油的空车开回营地。最后的思路基本上对了,虽然还有一些细节上的错误。

2. Gemini的数学功底就差多了。核心之外的话倒说得头头是道,就像文科生在做理科的题目。所以我说:看来Gemini还是一位“文艺呆(A Fuzzy)”,而不是一位“科技宅(A Techie)”。[据说在斯坦福大学,每人都被贴上“科技宅”或“文艺呆”的标签。见图书《The Fuzzy and the Techie》,中译本《文艺呆与科技宅》]。

大型语言模型是通用的模型,在广泛的任务中表现出色,而不是针对一项特定任务(例如数学推理)进行训练。所以在数学解题方面差强人意还能理解。

AI大模型是靠喂料而获得知识的。由于食材的选择性、限制性,要使通用大模型面面俱到不偏科的确是很难的。于是我找来几个以数学解题为核心的AI大模型:国产的九章MathGPT和MathGPTPro公司的MathGPTPro/Max进行测试。它们也几乎没把这个题目做出来,倒反不如通才ChatGPT。

通过测试,我还产生这样的感觉:这些AI大模型还缺乏人类智慧中两个极端方面的知识。

一个是缺乏人类的基本常识。例如:“没有油的空车不能开动”。几个AI大模型几乎都犯了同样的毛病,开着没油的空车来回跑。人类的一些基本常识并没有写入教科书,所以它们也无法从材料中学到这些常识。

另一个是缺少人类创造性的思维。这个题目并不难,大部分人稍微动点脑筋都可以做出来。除了ChatGPT想出一点眉目外,其他AI大模型都还找不到门。所以更谈不上掌握人类智慧中的奇思妙想了,例如像编程的Duff's device [ 达夫奇招;不应翻译成达夫设备-我过去的博客中说到过。]。

当然,这是仅凭一个具体的题目,做出的个人主观判断。所以我想在后续的博客里提供我与五个AI大模型就“沙漠取宝”问题对话的原始记录,以便大家根据原始对话,做出自己的分析、判断。

[1] 沙漠取宝问题(1) - 与ChatGPT的对话

[2] 沙漠取宝问题(2) - 与Gemini的对话

[3] 沙漠取宝问题(3) - 与九章MathGPT的对话

[4] 沙漠取宝问题(4) - 与MathGPT Max的对话

[5] 沙漠取宝问题(5) - 与MathGPT Pro的对话

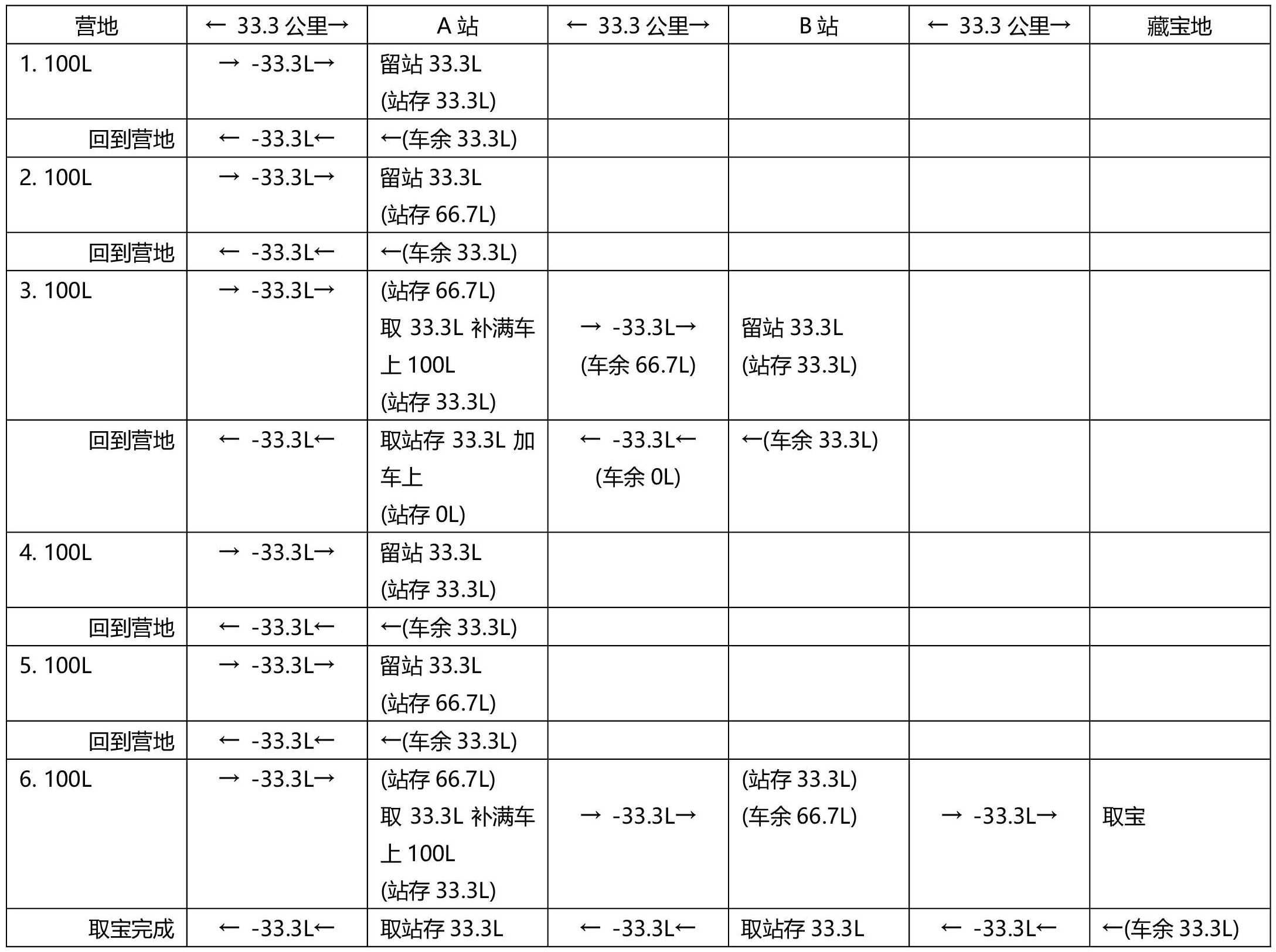

这里顺便提供一种取宝方案:考虑到补给站与营地、补给站与藏宝地、以及补给站与补给站之间的距离不能超过50公里,故至少要设立两个以上的补给站。下面是一种两个补给站的方案,两个站分别设在全程1/3、2/3的点上,经过六次运油,成功取回宝贝。看看大家能否提供更优的方案。

===

fy_zhu

2024-07-10 BOS-MA